Ihre Website hat nicht nur menschliche Besucher: Webcrawler, gelegentlich auch Webspider genannt, hangeln sich im digitalen Netz von Link zu Link und untersuchen die jeweiligen Inhalte genau. Warum Webcrawler für SEO ein echter Segen und keine Plage sind, erfahren Sie hier.

Inhalt

Was ist ein Webcrawler?

Ein Webcrawler ist ein Programm, das das Internet gezielt und automatisch nach bestimmten Informationen absucht. Die wohl bekannteste Funktion von Crawlern ist die Indexierung von Websites für Suchmaschinen.

Wie funktionieren Webcrawler?

Bei Webcrawlern, auch Searchbots oder Spiders genannt, handelt es sich um Programme, die Informationen im Internet automatisch durchforsten und dabei verschiedene Arten von Daten sammeln. Darunter fallen zum Beispiel HTML-Inhalte, Bilder, Skripte oder Dokumente. Hierfür sendet der Crawler zunächst eine HTTP-Anfrage an den Webserver der Ziel-URL, der mit einem Inhalt der Seite antwortet.

Im nächsten Schritt analysiert der Webcrawler die Inhalte und extrahiert dabei alle URLs, die ebenfalls gecrawlt werden. Diese Daten können im Anschluss gespeichert, sortiert und ausgewertet werden. Diesen Prozess wiederholt der Webcrawler-Bot so oft, bis keine neuen Links mehr gefunden werden oder bestimmte Kriterien erfüllt sind, beispielsweise die maximale Anzahl an Seiten.

Welche Arten von Webcrawlern gibt es?

Besonders bekannt sind die Webcrawler-Bots von Google. Sie sind verantwortlich, Webseiten in den Index der Suchmaschine zu überführen. Auch für andere Zwecke werden Crawler genutzt, zum Beispiel, um Daten über Produkte und ihre Preise zu sammeln und dann auf Portalen für Preisvergleiche darzustellen. Im Folgenden stellen wir Ihnen die wichtigsten Webcrawler-Arten und ihre Funktionen vor.

Google Webcrawler als Grundlage der Indexierung in Suchmaschinen

Wenn es sich um einen Google Webcrawler handelt, werden die Daten in Kategorien eingeordnet und nach exakt definierten Regeln in den Index der Suchmaschine übertragen.

Um den Index aktuell zu halten und Nutzern stets relevante Suchergebnisse anzeigen zu können, lässt Google seine Crawler Seiten nicht nur einmal auswerten. Nach einiger Zeit kehren die Bots zurück und prüfen, ob sich die Inhalte verändert haben. Erst durch Webcrawler werden Webseiten in Suchmaschinen auffindbar.

Achten Sie also darauf, dass Ihre Website eine klare Struktur und Navigation aufweist, einzelne Seiten intern gut miteinander verlinkt sind und die Metadaten mit relevanten Daten angereichert sind. Dabei kann es auch hilfreich sein, in der Google Search Console eine XML-Sitemap bereitzustellen.

Focus Crawler belohnen aktuelle Inhalte

Focus Crawler konzentrieren sich auf besonders aktuelle und somit relevante Inhalte und indexieren diese detaillierter als es bei herkömmlichen Webcrawlern üblich ist.

Google und Co. gehen davon aus, dass Inhalte im Regelfall veralten, wenn sie nicht regelmäßig aktualisiert werden. Deshalb besuchen ihre Bots Seiten, die nur gelegentlich oder gar nicht aktualisiert werden, seltener.

Für die Suchmaschinenoptimierung bedeutet das, dass es sich lohnt, den eigenen Content von Zeit zu Zeit auf den neusten Stand zu bringen und periodisch frische Inhalte zur Verfügung zu stellen. Diese sollten hochwertig und einzigartig sein.

Data Miner analysiert Big Data

Einige Webcrawler suchen speziell nach statistischen Daten, andere etwa nach Nachrichten. Auch öffentlich einsehbare Post- und E-Mail-Adressen sowie Telefonnummern können von den Bots eingesammelt werden. Dieser Prozess wird als „Data Mining“ bezeichnet und ist insbesondere für Marketingzwecke nützlich. Der Grund: Data Miner helfen dabei, Muster, Zusammenhänge und Anomalien in großen Datenmengen zu entdecken.

Deep-Webcrawler: Unsichtbare Inhalte analysieren

Normale Webcrawler können passwortgeschützte Bereiche und indexierte Inhalte in der Regel nicht durchsuchen. Hier kommen die Deep-Webcrawler zum Einsatz, die speziell dafür konzipiert sind, das Deep Web, auch Invisible Web genannt, zu analysieren. Erreichen kann der Webcrawler diese Aufgabe, indem er sich auf der Webseite anmeldet oder Suchanfragen in Suchfelder eingibt.

Webcrawler: Open Source für volle Flexibilität

Durch den offenen Quellcode können Open-Source-Crawler von jedem eingesehen, genutzt und modifiziert werden. Diese Art von Webcrawlern kann vielfältig eingesetzt werden, unter anderem zur Erstellung eines Suchindexes, zum allgemeinen Crawlen von Webseiten oder für das Sammeln von Daten zu Forschungszwecken.

Webcrawler blockieren: Schutz vor unerwünschten Besuchen

Normalerweise sind Crawler auf Webseiten gern gesehene Gäste – schließlich sorgen sie dafür, dass Internetnutzer und Internetnutzerinnen die Inhalte über Suchmaschinen finden können. Manchmal soll eine Seite aber gar nicht gefunden und somit auch nicht in den Index aufgenommen werden.

In diesem Fall können Webmaster Bots mittels der Datei „robots.txt“ und bestimmten Angaben im HTML-Header signalisieren, dass sie die fraglichen Inhalte nicht untersuchen sollen. Nicht immer verhindert das aber eine Indexierung! Vielversprechender ist an dieser Stelle der Einsatz von Meta-Tags wie dem noindex-Tag oder dem canonical-Tag.

Viele Webseitenbetreiber versuchen auch, das unerwünschte Sammeln von E-Mail-Adressen zu verhindern, indem sie deren Schreibweise verändern. Lautet der Text etwa „kontakt(at)beispieldomain(dot)de“, erkennen zahlreiche Bots nicht mehr, dass es sich dabei um eine E-Mail-Adresse handelt.

Herausforderungen von Webcrawlern

Neben den zahlreichen Möglichkeiten, die Webcrawler mit sich bringen, müssen sie sich auch einigen Problematiken stellen. Besonders dynamische Inhalte wie personalisierte Werbung erschweren die Arbeit, da sie sich je nach Person oder Standort verändern und Webcrawler somit Probleme mit der Indexierung haben.

Daneben verändert sich das Internet weiterhin rasant schnell und die Daten, die ausgelesen werden sollen, werden immer größer und komplexer. Deshalb ist es wichtig, dass Webcrawler eine hohe Skalierbarkeit sowie Geschwindigkeit aufweisen.

Sind Webcrawler legal?

Wenn das Webcrawling von einer Suchmaschine durchgeführt wird, die den Inhalt der Webseite im Index erfassen soll, handelt es sich um eine legale Praxis. Generell gibt es jedoch keine international geltende Regelung für das Crawlen.

Werden Inhalte von einem Webcrawler ohne Erlaubnis kopiert, was beispielsweise beim Data Mining vorkommen kann, handelt es sich oft um eine Grauzone. Sicherheitshalber sollten Webmaster daher die oben beschriebene robots.txt-Datei einfügen, denn eine Missachtung dieser ist illegal.

Webcrawler vs. Webscraper: Das sind die Unterschiede

Ein Scraper ist ähnlich konfiguriert wie ein Webcrawler und durchsucht das Internet automatisiert und wiederkehrend nach Informationen. Der Zweck ist allerdings ein anderer.

Scraper kopieren komplette Seiten und veröffentlichen sie in identischer oder leicht abgewandelter Form an anderer Stelle im Web. So sollen Internetseiten schnell und einfach mit hochwertigen, im Suchmaschinenranking weit vorne stehenden Inhalten gefüllt werden. Dadurch lässt sich gut Geld verdienen – beispielsweise über Werbeanzeigen.

Wieso ist das regelmäßige Crawling von Webseiten so wichtig?

Wird eine Webseite regelmäßig aktualisiert, sollten Suchmaschinen diese Änderungen im besten Fall erfassen. Regelmäßiges Crawling stellt sicher, dass die neuesten Inhalte in den Suchmaschinenindex aufgenommen werden. Das trägt auch dazu bei, dass Nutzerinnen und Nutzer aktuelle und relevante Informationen finden.

Beim Ranking berücksichtigen Suchmaschinen zudem verschiedene Faktoren, unter anderem die Aktualität der Inhalte. Wird eine Webseite nicht regelmäßig gecrawlt, ist es wahrscheinlich, dass veraltete Informationen das Ranking verschlechtern. Durch regelmäßiges Webcrawling wird auch der Status der Webseite überwacht und diese auf fehlerhafte Verlinkungen überprüft.

Die gängigsten Webcrawler: Anbieter im Überblick

Es gibt eine ganze Reihe an Webcrawlern, die genutzt werden. Nachfolgend gehen wir auf einige bekannte Webcrawler ein.

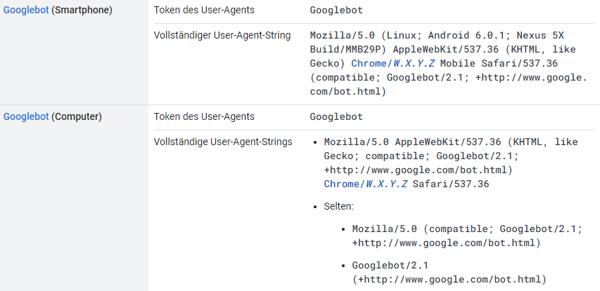

1. Googlebot

Googles Webcrawler Googlebot ist der bekannteste Crawler und dafür zuständig, Webseiten zu durchsuchen, die in der Suchmaschine angezeigt werden sollen. Der Bot crawlt die Seiten alle paar Sekunden, sofern keine robots.txt-Datei eingesetzt wurde. Das Back-Up der gecrawlten Seiten wird im Google Cache gespeichert, einer Datenbank, in der alte Versionen von Webseiten einsehbar sind.

Quelle: Screenshot Googlebot

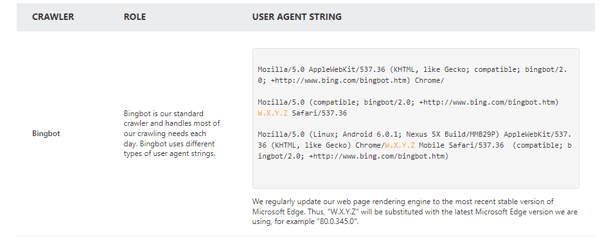

2. Bingbot

Bingbot ist der Webcrawler-Bot von Microsoft und funktioniert ähnlich wie der Crawler von Google. Daneben hat Bing noch vier weitere Bots, die das Web crawlen.

Quelle: Screenshot Bingbot

3. DuckDuck Bot

Mehr Privatsphäre bietet DuckDuckBot, der Crawler von DuckDuckGo. Beim Durchsuchen der Webseite aktualisiert der Bot die API-Datenbank mit den aktuellen User-Agents und IP-Adressen. Versuchen Malware-Bots oder Social Engineers, sich mit dem Bot zu verbinden, werden sie so dem Webmaster ausgeliefert.

Quelle: Screenshot DuckDuck Bot

4. Facebook External Hit

Der Facebook-Crawler Facebook External Hit crawlt den HTML-Code von Apps oder Webseiten, die in dem sozialen Netzwerk geteilt werden. So erstellt Facebook für jeden geposteten Link eine Vorschau inklusive Thumbnail, Titel und Beschreibung.

Quelle: Screenshot Facebook External Hit

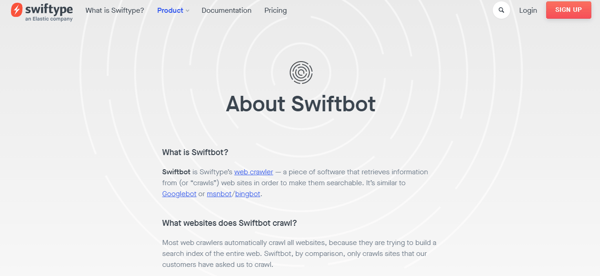

5. Swiftbot

Swiftbot, der Webcrawler von Swiftype, crawlt keine beliebigen Seiten, sondern nur solche, die angefordert werden. Besonders bei komplexen Sitemaps ist der Webcrawler hilfreich, um alle Webinhalte zu durchsuchen und indizieren.

Quelle: Screenshot Swiftbot

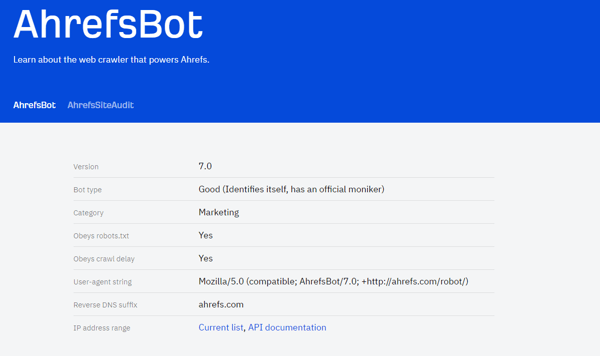

6. Ahrefs Bot

Der kommerzielle Webcrawler Ahrefs Bot ist hinter dem Googlebot auf Platz zwei, wenn es um die Anzahl an täglich gecrawlten Webseiten geht. Sechs Milliarden Websites werden täglich von dem Crawler der SEO-Software Ahrefs gesammelt und indexiert.

Quelle: Screenshot Ahrefs Bot

Weitere kommerzielle Anbieter von Webcrawlern sind:

- Semrush Bot

- Screaming Frog

- Lumar

- cognitiveSEO

Fazit: Webcrawler sind SEO-Helden

Jede Sekunde entstehen unzählige Inhalte, die im World Wide Web verbreitet werden. Damit Nutzer und Nutzerinnen primär relevante und sinnvolle Inhalte erhalten, müssen Webcrawler täglich Milliarden Webseiten durchsuchen und indizieren. Da sie den Webmastern so wertvolle Einblicke liefern und das Ranking in den Suchmaschinen beeinflussen, sind Webcrawler für SEO unabdingbar.

Gleichzeitig kann ein Webcrawler auch Probleme und Herausforderungen mit sich bringen, beispielsweise, wenn zu viele Anfragen zu einer Serverüberlastung führen, der Datenschutz verletzt wurde oder wenn dynamische Inhalte nicht erfasst werden.

Alles in allem sind sowohl kommerzielle als auch nicht-kommerzielle Webcrawler-Anbieter eine sinnvolle Lösung für Unternehmen, die in Sachen SEO und Webauftritt die volle Kontrolle haben wollen.

Titelbild: PashaIgnatov / iStock / Getty Images Plus

Ursprünglich veröffentlicht am 27. Juli 2023, aktualisiert am Juli 27 2023

Themen:

SEODiesen Artikel weiterempfehlen:

Artikel zu ähnlichen Themen

Mehr anzeigen

So erstellen Sie eine Inbound-Marketing-Kampagne

Herunterladen