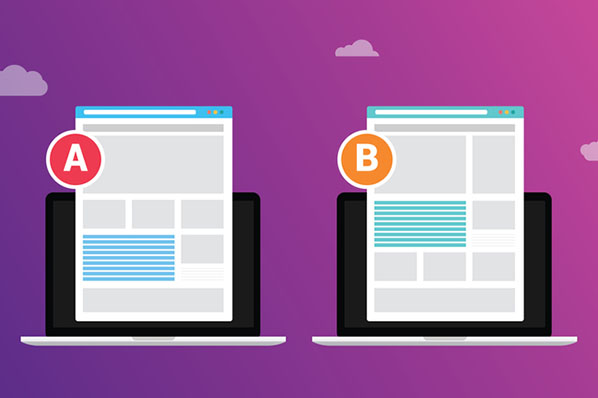

A/B-Tests, auch als „Split-Tests“ bezeichnet, sind die effektivste Methode, um Ihre Onlinepräsenz messbar (und auf wissenschaftlich fundierte Weise) zu verbessern. Dabei werden zeitgleich zwei Versionen eines Content-Elements, z. B. einer Landing-Page, verschiedenen gleich großen Zielgruppen zur Verfügung gestellt, und untersucht, welche Version die besseren Ergebnisse erzielt. Im Marketing setzt man großes Vertrauen in A/B-Tests, und das aus gutem Grund: Richtig gemacht können diese Tests konkrete Anhaltspunkte dafür liefern, mit welchen Veränderungen sich die Konversionsrate ausgewählter Content-Elemente verbessern lässt. Somit müssen Sie sich nicht mehr auf reine Spekulationen verlassen.

Im Internet kursieren jedoch zahlreiche Fragen, wie A/B-Tests korrekt durchzuführen sind.

Um Ihnen und vielen anderen Benutzern den Einstieg in A/B-Tests zu erleichtern, haben wir die auf LinkedIn, Quora und Focus am häufigsten gestellten Fragen zu A/B-Tests in dieser Liste zusammengetragen und beantwortet. Wir hoffen, dass die Antworten auf diese häufig gestellten Fragen zu A/B-Tests für Sie hilfreich sein werden.

1. Für welche Szenarien eignen sich A/B-Tests?

Wenn A/B-Tests keine brauchbaren Ergebnisse liefern, liegt das häufig daran, dass keine klaren Ziele festgelegt wurden. Sie müssen also genau wissen, was Sie testen möchten. Nutzen Sie A/B-Tests, um eine Theorie zu testen, beispielsweise um festzustellen, ob sich durch Einfügen eines Bilds auf einer bestimmten Landing-Page eine höhere Konversionsrate erzielen lässt. Klicken Website-Besucher eher auf eine rote oder eine blaue Schaltfläche? Was passiert, wenn ich die Überschrift ändere, um auf die zeitliche Beschränkung eines Angebots hinzuweisen?

All diese Änderungen lassen sich problemlos quantifizieren. A/B-Tests sind nur dann problematisch, wenn die getesteten Theorien zu vage sind, beispielsweise wenn Sie zwei völlig unterschiedliche Designs mit mehreren Varianten testen. Ein solcher Ansatz ist zwar durchaus denkbar, das Ergebnis ist jedoch oftmals eher unbefriedigend. Sofern es keinen klaren Gewinner gibt, lassen sich beim Testen unterschiedlicher Designs nämlich häufig keine eindeutigen Schlussfolgerungen ziehen und somit bleibt ungewiss, worauf ein möglicher Anstieg der Konversionsrate zurückzuführen ist.

2. Wie viele Varianten sollte man bei einem A/B-Test testen?

Nehmen wir an, Ihr Marketingteam hat vier Ideen für ein Landing-Page-Design entwickelt. Da ist man natürlich versucht, alle vier Designs gleichzeitig zu testen, um die Version mit der besten Performance zu ermitteln. Ähnlich wie beim oben erwähnten Beispiel mit den Varianten wäre das kein echter A/B-Test, denn Sie würden ja vier unterschiedliche Varianten gleichzeitig testen. Dabei könnten verschiedene Faktoren aus den unterschiedlichen Designs das Testergebnis verfälschen. Der Vorteil eines A/B-Tests liegt jedoch gerade darin, dass die Ergebnisse klar und eindeutig sind. Daher würden wir in einem solchen Szenario empfehlen, jeweils nur zwei Versionen miteinander zu vergleichen und die resultierenden Gewinner anschließend in einem zweiten Test einander gegenüberzustellen.

3. Was ist eine Nullhypothese?

Eine Nullhypothese bezeichnet die Hypothese, dass unterschiedliche Ergebnisse auf einen Stichprobenfehler oder eine Standardabweichung zurückzuführen sind. Wenn Sie beispielsweise eine Münze werfen, ist die Chance, dass die Münze Kopf oder Zahl zeigt, 50:50. In der Praxis kann das Ergebnis abhängig vom Zufall aber auch 51:49 oder ein ähnliches Ergebnis sein. Je häufiger Sie die Münze werfen, desto näher kommen Sie dem Verhältnis von 50:50. In der Statistik versucht man, die Nullhypothese zu entkräften, um eine Idee zu beweisen oder zu widerlegen. Dabei geht es darum, das Experiment lange bzw. häufig genug durchzuführen, um ein zufälliges Ergebnis auszuschließen. Dieses Konzept wird auch als das Erreichen statistischer Signifikanz bezeichnet.

4. Wie häufig müsste eine Website aufgerufen werden, um ein gutes A/B-Testergebnis zu erzielen?

Bevor Sie die Ergebnisse eines A/B-Tests testen können, müssen Sie sichergehen, dass der Test statistische Signifikanz erreicht hat, d. h. die Ergebnisse müssen eine Zuverlässigkeit von mindestens 95 % aufweisen.

Viele Tools für A/B-Tests zeigen automatisch an, wenn die Ergebnisse statistische Signifikanz haben und interpretiert werden können. Wenn eine solche Funktion nicht vorhanden ist, können Sie mithilfe kostenloser Rechner und Tools die statistische Signifikanz eines Tests berechnen.

5. Was sind multivariate Tests und wie unterscheiden Sie sich von A/B-Tests?

A/B-Tests werden normalerweise für überarbeitete Designs verwendet, um die Effektivität einer Designrichtung im Hinblick auf ein bestimmtes Ziel (z. B. Steigerung der Konversionsrate) zu testen. Multivariate Tests werden insbesondere zum Testen kleinerer Veränderungen über einen längeren Zeitraum hinweg verwendet. Dabei werden mehrere Elemente auf einer Website in allen möglichen Kombinationen getestet, um die Website laufend zu optimieren. Corey Wainwright erklärt die Unterschiede zwischen den beiden Testmethoden und ihre Anwendungsbereiche im Detail:

A/B-Tests stellen eine hervorragende Testmethode dar, wenn es darum geht, schnell aussagekräftige Ergebnisse zu erhalten. Aufgrund der starken Veränderungen zwischen den verschiedenen Testversionen lässt die besser performende Version damit recht einfach ermitteln. Diese Testmethode eignet sich auch hervorragend für Websites, die nicht allzu viel Traffic aufweisen. Da bei multivariaten Tests (MVT) mehrere Variablen getestet werden, muss die getestete Website sehr viel Traffic aufweisen, um mit dieser Testmethode aussagekräftige Ergebnisse zu erhalten.

Wenn Ihre Website ausreichend Traffic aufweist, um einen multivariaten Test erfolgreich durchführen zu können (obwohl Sie auch hier A/B-Tests zum Testen ganz neuer Designs und Layouts einsetzen können), eignet sich diese Testmethode insbesondere bei geringfügigen Änderungen auf einer Seite, um festzustellen, wie bestimmte Elemente miteinander interagieren. Auf diese Weise lässt sich das bestehende Design schrittweise verbessern.

6. Haben A/B-Tests negative Auswirkungen auf die SEO?

Irrtümlicherweise wird häufig angenommen, dass A/B-Tests negative Auswirkungen auf das Suchmaschinenranking haben, da der getestete Content als „Duplicate Content“ klassifiziert werden könnte, der von Suchmaschinen gegebenenfalls abgestraft wird. Dies ist definitiv nicht der Fall. Matt Cutt von Google empfiehlt sogar, A/B-Tests zu nutzen, um die Funktionalität einer Website zu verbessern. Auch Website Optimizer klärt diesen Irrtum auf und erläutert, warum an dieser weit verbreiteten Meinung nichts dran ist. Wenn Sie dennoch Ihre Zweifel haben, können Sie Seiten, die Sie als Testversionen nutzen, mit einem „no index“-Tag versehen. Ausführliche Anweisungen zum Einfügen eines „no index“-Tags finden Sie hier.

7. Wie und wann sollte ich die Ergebnisse eines A/B-Tests interpretieren?

Sie sollten nicht versuchen, Ergebnisse schon in den ersten Phasen eines Tests zu interpretieren. Warten Sie, bis der Test statistische Signifikanz erreicht hat (siehe Abschnitt 4) und sehen Sie sich die ursprüngliche Hypothese nochmal genau an. Konnte die Hypothese durch den Test eindeutig bewiesen oder widerlegt werden? Wenn dies der Fall ist, können Sie erste Rückschlüsse ziehen. Bei der Interpretation des Tests müssen Sie darauf achten, dass Sie die Ergebnisse richtig mit den einzelnen Änderungen verknüpfen. Zwischen Änderung und Ergebnis muss eine klare Verbindung bestehen, und es dürfen keine anderen Faktoren eine Rolle spielen.

8. Wie viele Variablen sollten getestet werden?

Ein A/B-Test sollte eine gewisse Aussagekraft haben und klare, umsetzbare Ergebnisse erzeugen, sonst verschwenden Sie nur Ihre Zeit. Beim gleichzeitigen Testen mehrerer Variablen lässt sich allerdings nicht genau feststellen, welche Variable letztlich für unterschiedliche Ergebnisse verantwortlich ist. Sie können zwar ermitteln, mit welcher Testversion bessere Resultate erzielt wurden. Wenn ihr Test jedoch drei oder vier Variablen umfasst, können Sie weder zweifelsfrei feststellen, welche Variable einen negativen Einfluss hatte, noch die guten Elemente herausfiltern, um sie auf Ihrer Website zu implementieren. Unsere Empfehlung? Führen Sie eine Reihe von Tests mit jeweils nur einer Variable durch, um eine Seite schrittweise zu optimieren.

9. Welche Elemente sollte ich testen?

Was Sie testen möchten, ist natürlich Ihnen überlassen. Wir empfehlen jedoch, zunächst einige grundlegende Elemente Ihrer Webseite zu testen.

- Calls-to-Action: Selbst bei einem einzelnen Element wie einem Call-to-Action können Sie verschiedene Aspekte testen. Sie müssen sich jedoch klar darüber sein, welchen Aspekt des CTA Sie genau testen möchten. Sie können den Text testen – wozu der CTA die Besucher bewegen soll; die Position – wo der CTA auf einer Seite positioniert ist; die Form und den Stil – wie der CTA aussieht. Im Beispiel unten testete HubSpot die Form und den Stil des CTA für eine Produktdemo, um zu ermitteln, welches Design besser bei den Besuchern ankam. Der CTA in Form einer Schaltfläche (rechts) erzielte im Gegensatz zum CTA mit dem HubSpot-Logo (links) wesentlich bessere Ergebnisse und füührte zu einer Steigerung der Konversionsrate um 13 %.

- Überschrift: Die Überschrift wird von Besuchern einer Webseite normalerweise zuerst gelesen und kann einen erheblichen Einfluss haben. Probieren Sie bei Ihren A/B-Tests daher verschiedene Varianten einer Überschrift aus. Achten Sie auf deutliche Unterschiede zwischen den Aussagen der einzelnen Versionen. Sind die Unterschiede zu subtil, lassen sich keine aussagekräftigen Schlüsse ziehen.

- Bilder: Was zeigt mehr Wirkung: ein Bild einer Person, die Ihr Produkt verwendet, oder ein Bild, auf dem nur das Produkt abgebildet ist? Testen Sie unterschiedliche Versionen Ihrer Seite mit verschiedenen Bildern, um herauszufinden, ob sich dadurch das Besucherverhalten ändert.

- Textlänge: Können Sie Ihre Botschaft auf der Seite besser vermitteln, wenn Sie den Text kürzen, oder müssen Sie Ihr Angebot etwas ausführlicher erklären? Probieren Sie verschiedene Formulierungen und Textversionen aus, um herauszufinden, wie ausführlich die Erläuterungen für die Leser sein müssen, um sie zu überzeugen und letztendlich zu konvertieren. Damit dieser Test funktioniert, sollten Sie ähnliche Texte mit unterschiedlichen Textlängen ausprobieren.

10. Lassen sich A/B-Tests auch auf andere Elemente als nur Websites anwenden?

Ja! Viele Marketer führen A/B-Tests nicht nur für Landing-Pages und anderen Seiten aus, sondern testen auch E-Mails, PPC-Kampagnen und Calls-to-Action.

- E-Mails: Zu Variablen, die bei E-Mails getestet werden können, gehören u. a. die Betreffzeile, Personalisierungsfunktionen, Name des Absenders usw.

- PPC-Anzeigen: Bei Werbeanzeigen in Suchergebnissen können Sie einen A/B-Test für die Überschrift, den Haupttext, den Link-Text oder Keywords durchführen.

- CTAs: Sie den Text auf dem CTA, sowie seine Form, Farbe oder Platzierung auf der Seite verändern.

11. Wie finde ich A/B-Tests von ähnlichen Unternehmen?

Im Internet gibt es einige Websites, auf denen Beispiele für A/B-Tests und die zugehörigen Ergebnisse zusammengefasst sind. Auf manchen Websites können Sie nach Unternehmenstyp suchen und meistens wird im Detail erläutert, wie ein Unternehmen seine Testergebnisse interpretiert hat. Wenn Sie selbst erste A/B-Tests durchführen möchten, sollten Sie sich ein paar Anregungen holen, was Sie in Ihrem Unternehmen am besten testen könnten:

- Visual Website Optimizer: Wie HubSpot auch stellt Visual Website Optimizer Software für A/B-Tests bereit und veröffentlicht in seinen Blogs eine Reihe von Beispielen als Anschauungsmaterial.

- Neil Patel gibt in diesem Artikel ebenfalls einige Anregungen.

12. Was kann ich tun, wenn ich den Ergebnissen eines Tests nicht vertraue?

Wenn Sie den Ergebnissen wirklich nicht vertrauen und Fehler oder Probleme im Hinblick auf die Gültigkeit des Tests ausgeschlossen haben, sollten Sie den Test am besten einfach erneut durchführen. Gehen Sie dabei so vor, als würde es sich um einen komplett neuen Test handeln, und beobachten Sie, ob Sie dieselben Ergebnisse erhalten. Wenn Sie jedes Mal wieder dieselben Ergebnisse erhalten, sind diese Ergebnisse vertrauenswürdig.

13. Wie häufig sollte ich A/B-Tests durchführen?

Hier gehen die Meinungen auseinander. Vieles spricht für ein kontinuierliches Testen Ihrer Website. Achten Sie jedoch darauf, dass jeder Test ein klares Ziel hat und dazu beiträgt, die Website für die Besucher und Ihr Unternehmen zu optimieren. Wenn Sie zahlreiche Tests durchführen, die nur unbedeutende Resultate liefern, sollten Sie Ihre Teststrategie überdenken.

14. Was brauche ich, um für meine Website A/B-Tests durchzuführen?

Für A/B-Tests können Sie am besten ein spezielles Softwaretool verwenden. HubSpot bietet ein solches Tool etwa im Rahmen seiner Marketingsoftware an. Weitere Anbieter von Testtools sind Unbounce und Visual Website Optimizer. Wenn Sie sich nicht davor scheuen, selbst Hand beim Code Ihrer Website anzulegen, können Sie auch die Funktion für Content-Tests von Google Analytics nutzen. Diese unterscheidet sich jedoch ein wenig von den herkömmlichen A/B-Testmethoden. Wenn Sie technisch etwas versiert sind, lohnt sich ein Versuch.

15. Abgesehen von der Stichprobengröße, welche Faktoren können die Gültigkeit eines Tests beeinträchtigen?

MECLABS hat letztes Jahr eine hervorragende Web Clinic zu einer Reihe von Faktoren gegeben, die die Gültigkeit eines Tests bedrohen können. Dabei erläuterte Dr. Flint McGlaughlin drei Testfehler und erklärte, wie sich diese Fehler vermeiden lassen. Es empfiehlt sich, das gesamte Transkript der Web Clinic zu lesen. Nachstehend werden einige Fehler aus der Liste erläutert.

- „History Effect“: Ereignisse, die nicht mit dem Test in Zusammenhang stehen, haben einen negativen Einfluss auf die Testergebnisse (z. B. Naturkatastrophen, politische Ausnahmesituationen usw.)

- „Instrumental Effect“: Ein Fehler in der Test-Software beeinflusst die Testergebnisse.

16. Sollte ich für meine Homepage A/B-Tests durchführen?

Sie sollten A/B-Tests für Ihre Homepage nicht generell ausschließen. Es kann sich jedoch als recht schwierig erweisen, bei einem Test Ihrer Homepage schlüssige Ergebnisse zu erhalten. Denn eine Homepage bekommt meist sehr unterschiedliche Arten von Traffic, von zufälligen Besuchern bis hin zu Leads oder Kunden. Zudem weist eine Homepage üblicherweise sehr viel Content auf. Daher lässt sich unter Umständen nur schwer feststellen, welche Faktoren das Besucherverhalten beeinflussen.

Und da eine Homepage von ganz unterschiedlichen Benutzern besucht wird, ist es nicht ganz einfach, ein Ziel für die Seite festzulegen und einen entsprechenden Test durchzuführen. Wenn Sie beispielsweise die Konversion von Leads in Kunden als Testziel festlegen, die Besucher während des Tests jedoch hauptsächlich aus Kunden anstelle von Interessenten bestehen, könnte sich das Ziel für diese Gruppe verlagern. Wenn Sie Ihre Homepage testen möchten, sollten Sie sich auf das Testen von CTAs beschränken.

17. Was kann ich tun, wenn ich keine Kontrollversion habe?

Unter „Kontrollversion“ wird die bestehende Version eines Content-Elements verstanden, mit der die Variante während des Tests verglichen wird. Es kann auch vorkommen, dass Sie zwei Versionen eines bisher noch nicht bestehenden Elements testen möchten, auch das ist möglich. In diesem Fall legen Sie einfach eine Variante als Kontrollversion fest. Wählen Sie dabei die Variante, die in puncto Design am ehesten dem aktuellen Design Ihrer Website entspricht. Die andere Version dient dann als Testvariante.

18. Warum kommt bei einem A/B-Test kein Verhältnis von 50:50 zustande?

Bei einem A/B-Test kann es vorkommen, dass das Traffic-Aufkommen der einzelnen Varianten nicht identisch ist. Das deutet nicht auf einen Fehler im Test hin, sondern zeigt vielmehr, dass bei einem solchen Test auch der Zufall eine Rolle spielt. Wenn Sie beispielsweise eine Münze werfen, ist die Chance, dass die Münze Kopf oder Zahl zeigt, 50:50. Manchmal landet die Münze jedoch auch dreimal hintereinander auf derselben Seite. Mit steigender Besucherzahl sollten Sie sich jedoch der 50:50-Marke annähern.

Diese Antworten auf häufig gestellte Fragen zu A/B-Tests waren längst überfällig.

Conversion