Erinnern Sie sich noch daran, wie Ihre Website ausgesehen hat, als Sie sie zum ersten Mal live geschaltet haben? Und wie viel Arbeit Sie sich damals gemacht haben, die Struktur der Website zu planen? Doch wie gut der Plan auch war: Mit der Zeit kommen immer neue Inhalte dazu, neue Themengebiete werden erschlossen und aus der ehemals organisierten Website wird ein Sammelsurium von Content und/oder Produkten. Ein Frühjahrsputz kann helfen, wieder mehr Ordnung in die eigene Website zu bringen.

Zuerst geht es darum, die vorhandenen Inhalte zu erfassen (Content-Inventur) und anschließend die Informationsarchitektur zu analysieren und zu optimieren. Beides zusammengenommen führt dazu, für Nutzer und Suchmaschinen gleichermaßen einen noch besseren Webauftritt zu erstellen. Wie das im Detail geht, verraten wir Ihnen in diesem Artikel.

Content-Inventur und Keyword Mapping: Welche Inhalte gibt es überhaupt?

Bevor der Frühjahrsputz beginnen kann, müssen Sie sich erstmal einen umfassenden Überblick über die eigene Website verschaffen. Da nur sehr wenige Webmaster eine Keyword Map, also eine Übersicht von Themen und Landing-Pages, erstellt haben und pflegen, ist es meistens gar nicht so einfach, die Frage zu beantworten, welche Inhalte man eigentlich auf der eigenen Website hat. Eine Keyword Map kann z. B. eine einfache Tabelle sein, in der die Seitenthemen (z. B. Informationsarchitektur) aufgeführt werden und diesen jeweils genau eine Adresse zugeordnet wird. Werfen Sie dazu am besten einen Blick auf die Tabelle am Ende dieses Artikels zu Themenclustern. Doch was tun, wenn Sie eine solche Übersicht aktuell nicht haben? Wie können Sie eine solche Übersicht mit möglichst wenig Aufwand erstellen?

Content-Inventur mit Hilfe von Crawlern durch die Betrachtung von Seitentitel & Co. erstellen

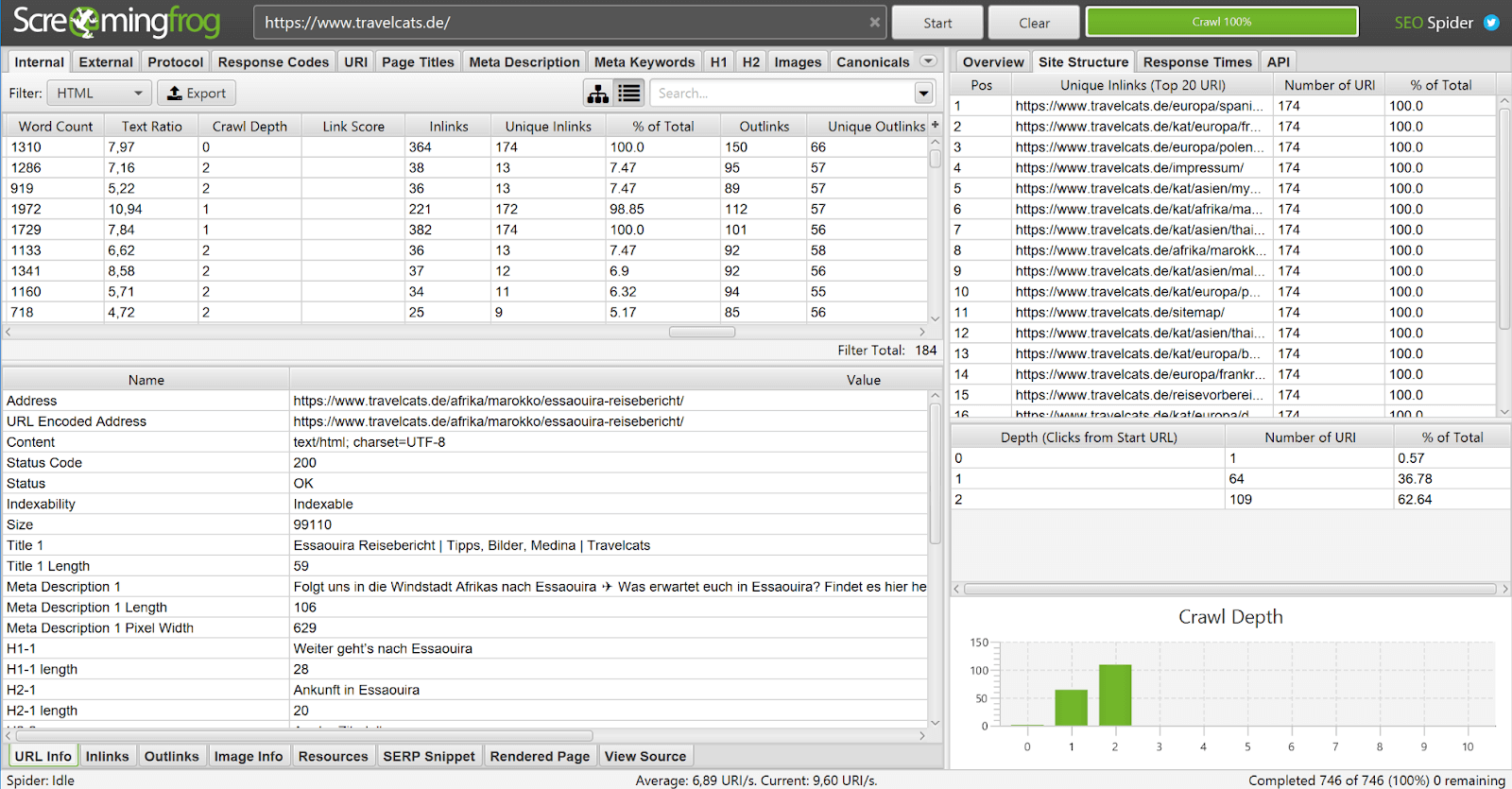

Wenn Sie Ihre Inhalte in der Vergangenheit gut suchmaschinenoptimiert haben, dann reicht ein Blick auf Seitentitel, Adresse und Hauptüberschrift, um das Thema einer Seite zu erfassen. Diese Daten müssen Sie nicht von Hand zusammentragen, denn das können Crawler für Sie übernehmen. Tools wie Screaming Frog (kostenfrei für bis zu 500 Adressen) oder Beam Us Up (kostenfrei) können Sie hierbei unterstützen. Alternativ können Sie Crawler wie beispielsweise Ryte, Sitebulb, Deepcrawl oder audisto verwenden. Die Liste ist dabei bei weitem nicht vollständig! Ganz gleich, welches Tool Sie nutzen, Sie erhalten eine Übersicht wie diese:

Die vom Crawler zusammengetragenen Daten können Sie in Tabellenform exportieren und anschließend weiterverarbeiten.

Sollten Sie anhand von Seitentitel, Überschrift, URL und Co. nicht auf das Seitenthema schließen können, dann bleibt Ihnen die Option, das Thema durch Lesen eines Artikels zu bestimmen oder bestehende Rankings zu analysieren.

Ein Tipp: Technisch versierte Webmaster können allerdings auch auf WDF-IDF-Tools zurückgreifen, um besonders wichtige Terme einer Seite automatisch zu bestimmen. Aber auch hier gilt: Ist der Text nicht gut optimiert, dann fällt es Tools schwer, passende Ergebnisse zu liefern.

SEO-Tools zur Content-Inventur nutzen

Natürlich sind Crawler auch SEO-Tools, aber warum nicht auf Tools zurückgreifen, die Ihnen verraten, für welche Keywords eine Seite aktuell schon rankt? Neben kostenpflichtigen Tools wie Sistrix, SEMrush oder Searchmetrics gibt es mit der Google Search Console eine kostenfreie Alternative.

Innerhalb des Performanceberichts können Sie sehen, welche Suchbegriffe für Aufrufe einzelner Adressen gesorgt haben. Am besten nutzen Sie Tools wie Search Analytics for Sheets, um die Daten über die Google Search Console API direkt in Tabellenform mit Zuordnung von Suchanfrage (Keyword) zu Seite zu erhalten.

Die Methode hat allerdings einen Nachteil: Meistens verfügt nur ein Bruchteil aller Seiten einer Website überhaupt über nennenswerte Zugriffszahlen – über Suchmaschinen und auch insgesamt.

Bei Adressen ohne nennenswerte Rankings stellt sich natürlich immer die Frage, warum dies so ist. Liegt es an On-page-Problemen und damit fehlender Relevanz, beispielsweise weil wichtige Seitenelemente schlecht optimiert wurden? Oder liegt es an duplizierten Inhalten oder gar daran, dass die Keyword-Recherche vergessen wurde? Hier hilft meistens nur ein geschulter Blick auf die Website insgesamt und die einzelnen Seiten.

Struktur-Analyse: Wie gut ist eine Seite über Links erreichbar?

Erfolg in Suchmaschinen haben Sie immer dann, wenn Sie Inhalte anbieten, die gut auf Nutzerbedürfnisse abgestimmt und gut erreichbar sind – sowohl innerhalb Ihrer Website, als auch im Web insgesamt. Denn dann kommen Relevanz (On-page-Optimierung) und Popularität (Off-page-Optimierung) zusammen und Ihre Inhalte sind im Gerangel um die Top-Positionen für nachgefragte Keywords gerüstet.

Wenn Sie über eine Content-Inventur herausgefunden haben, welche Inhalte Sie zur Verfügung haben, sollten Sie sich die Frage stellen, welche dieser Themen für Sie von besonderer Bedeutung sind. Daraufhin folgt die Frage, ob Ihre Website-Struktur dies auch abbildet. Denn es sollte Ihr Ziel sein, wichtige Adressen möglichst häufig und direkt erreichbar zu machen.

Dabei sollten Sie zudem darauf achten, dass die Ankertexte den Seiteninhalt für Nutzer verständlich zusammenfassen und sie zum Anklicken verleiten. Ein Ankertext wie „Pillar Pages” beschreibt den Inhalt dieser verlinkten Adresse beispielsweise besser als „hier”.

Jetzt fragen Sie sich vielleicht, wie Sie mit möglichst geringem Aufwand eine Struktur-Analyse starten und Ihre aktuelle Informationsarchitektur (oder Website-Struktur) analysieren können. Die Antwort: Wiederum mit Crawlern.

Nehmen wir wieder stellvertretend den Screaming Frog (ja, eines meiner Lieblings-SEO-Tools!).

Das Tool zeigt Ihnen für jede einzelne Adresse:

- Crawl Depth (Klicktiefe): Mit wie vielen Klicks ist die Adresse von der Startseite aus auf dem kürzest möglichen Weg erreichbar? Eine direkt von der Startseite aus verlinkte Seite ist demnach auf Seitenebene 1.

- Unique Inlinks (Anzahl einzigartiger eingehender Links): Wie viele interne Links zeigen auf die Adresse, wenn pro verlinkender URL (Adresse) nur ein Link gezählt wird?

- Inlinks (Anzahl eingehender Links): Wie viele Links sind es insgesamt, wenn mehrfach auftretende Verlinkungen gezählt werden?

- Unique Outlinks (Anzahl einzigartiger ausgehender Links): Wie viele Adressen macht diese Seite erreichbar, wenn jedes Linkziel nur einmal gewertet wird?

- Outlinks (Anzahl ausgehender Links): Wie viele ausgehende Links sind es auf der Seite insgesamt?

Darüber hinaus zeigt der Screaming Frog im rechten Bereich unter „Site Structure”, welche Adressen am häufigsten verlinkt sind und wie viele Klicks auf kürzestem Weg benötigt werden, um jede Adresse zu erreichen. Bei der im Screenshot gezeigten Website travelcats.de ist jedes Dokument innerhalb von maximal zwei Klicks erreichbar – ein sehr guter Wert. Hier kommt allerdings der Vorteil zum Tragen, dass die Seite weniger als 200 Seiten besitzt. Bei Websites mit mehr Inhalten ist es nicht untypisch, wenn eine deutlich zweistellige Anzahl an Klicks notwendig ist, um jede Adresse auf kürzestem Klickweg zu erreichen.

Natürlich können Sie sich auch die Ankertexte anschauen, mit denen Seiten verlinkt sind. Dazu können Sie sich die eingehenden Verlinkungen (Inlinks) genauer anschauen. Für gute interne Ankertexte empfiehlt es sich, Formulierungen zu verwenden, die für die Zielseite relevant sind.

Worauf sollten Sie also achten? Ihre wichtigsten Seiten sollten …

- mit möglichst wenigen Klicks von der Startseite aus erreichbar sein, also eine geringe Klicktiefe haben.

- möglichst häufig von ähnlichen Seiten erreichbar sein, also viele unique Inlinks aus möglichst passenden Umfeld haben.

- zu den am häufigsten verlinkten Adressen der Website gehören.

- mit inhaltsbeschreibenden Ankertexten oder Alt-Texten (wenn der Link auf einem Bild gesetzt ist) verlinkt werden.

Falls Sie diese Anforderungen für einzelne Adressen noch nicht erfüllen, helfen Ihnen die nachfolgenden Tipps dabei, die Informationsarchitektur Ihrer Website zu verbessern. Denn eine bessere Erreichbarkeit führt, entsprechende Relevanz der Zielseite vorausgesetzt, häufig zu besserem Ranking in den Suchergebnissen. Achten Sie in diesem Zusammenhang darauf, dass Links tendenziell wertvoller sind, wenn die Seite selbst sehr gut intern wie extern verlinkt ist. Gibt es eventuell Seiten auf Ihrem Webauftritt, die intern stark verlinkt sind, aber nur wenige Adressen Ihrer Website erreichbar machen?

Kleiner Tipp am Rande: Viele Crawler erlauben es, direkt Daten von SEO-Tools beim Crawling mit abzufragen. So kann beispielsweise „Screaming Frog“ Daten der Google Search Console direkt mit abfragen.

Vier Methoden, um die Website-Struktur zu optimieren

Wichtige Seiten direkt von der Startseite aus erreichbar machen

In der Regel ist es die Startseite, die am häufigsten intern wie extern verlinkt ist. Entsprechend ist diese Adresse eine sehr starke Verteilerseite, auf der regelmäßig viele Besucher landen.Nutzen Sie die Stärke dieser Seite, um ihre wichtigen Adressen direkt zu verlinken. Gehen Sie dabei aber durchaus geizig bei der Auswahl der zu verlinkenden Adressen vor. Hier gilt der Grundsatz „weniger ist mehr“, denn je mehr Seiten verlinkt werden, desto weniger Autorität wird über den Link weitergegeben.

Die Hauptnavigation oder den Footer zur Verlinkung wichtiger Adressen nutzen

Eine einfache Möglichkeit, um mehr interne Links für eine Seite zu generieren, sind die Elemente, die auf vielen oder gar allen Seiten identisch sind. Meistens sind das die Hauptnavigation oder der Footerbereich. Beide Seitenbereiche sind für die Strukturoptimierung wichtig und ein guter SEO-Hebel.

Die Sortierung auf Übersichtsseiten überdenken

Besonders Blogs tendieren dazu, Inhalte ausschließlich nach Datum zu sortieren und neue vor älteren Artikeln anzuzeigen. Was bei Websites mit tagesaktuellem Bezug wie Zeitungen erstmal sinnvoll ist, hat aus SEO-Sicht einen entscheidenden Nachteil: Ältere Artikel werden mit jedem neuen Artikel tendenziell intern schlechter erreichbar – und sinken in der Folge häufig im Suchmaschinenranking ab. Denn warum sollten Google & Co. denken, dass Inhalte relevant sind, wenn diese innerhalb der Website nur schwer erreichbar sind? Und warum sollte ein älterer Artikel pauschal weniger wichtig sein?

Reservieren Sie am besten einen Platz auf Ihrer Website, der Ihre Evergreen-Artikel gut erreichbar macht. Wie wäre es zum Beispiel mit einem Bereich mit Links zu den am häufigsten gelesenen Artikeln?

Nutzen Sie zusätzliche Kategorien, um Inhalte besser zu verteilen

Für die Struktur Ihrer Website kann es förderlich sein, wenn Sie relevante Unterkategorien erstellen und nicht alle Inhalte nur unter einer Oberkategorie gruppieren. Diese feineren Kategorien helfen Ihnen womöglich auch dabei, neue relevante Keywords abzudecken! Haben Sie beispielsweise viele Inhalte zuerst unter „SEO” zusammengefasst, merken aber dann, dass Sie auch für „On-page-SEO” viele Artikel haben, dann könnte das eine sinnvolle Unterkategorie sein.

Fazit: Überlassen Sie Ihr SEO-Ranking nicht dem Zufall

Mit den vorgestellten Werkzeugen in der Hand sollte es Ihnen leichter fallen, weiter oben in den organischen Suchergebnissen zu landen. Achten Sie immer darauf, dass ihre wichtigsten Seiten nicht nur im Hinblick auf die On-page-SEO gut dastehen, sondern von Ihren Besuchern innerhalb Ihrer Website leicht zu finden sind.

Wenn Sie noch tiefer gehen wollen: Einer Content-Inventur können Sie ein Content-Audit folgen lassen, in dem die Inhalte nochmal genauer durchleuchtet werden. Welche Inhalte müssten aktualisiert werden? Welche Seiten sind zu ähnlich und sollten in einem Artikel zusammengeführt werden? Welche Inhalte haben noch Lücken, die geschlossen werden sollten? Wo bieten Wettbewerber deutlich mehr Informationen und stehen dadurch womöglich höher in den Suchergebnissen? Oder gibt es gar Artikel, die komplett von der Website gelöscht werden können?

Trauen Sie sich ruhig, Inhalte zu entfernen, die nicht länger relevant sind. Denn je höher der Anteil an hochwertigen Inhalten an allen Inhalten Ihrer Website ist, desto relevanter ist Ihre Website für Nutzer und Suchmaschinen gleichermaßen.

Bei diesem Artikel handelt es sich um einen Gastbeitrag von Stephan Czysch, Gründer und Geschäftsführer der Berliner Online-Marketing-Agentur Trust Agents.

SEO

.png)

%20(27).png)